|

80 anni di ricerca: dal test di Alan Turing degli anni '50 ad oggi. Breve storia dell'IA dal passato al futuro

L'intelligenza artificiale è una disciplina appartenente all'informatica che studia i fondamenti teorici, le metodologie e le tecniche che consentono la progettazione di sistemi hardware e sistemi di programmi software capaci di fornire all'elaboratore elettronico prestazioni che, a un osservatore comune, sembrerebbero essere di pertinenza esclusiva dell'intelligenza umana.

(Marco Somalvico)

Fin dai primi giorni di questa lunga storia, moltissimi scienziati informatici si sono uniti per tendare di rendere le macchine intelligenti quanto gli esseri umani. Da Turing alle moderne applicazioni di Deep Learning sono passati decenni di duro lavoro creando algoritmi e software sempre più raffinati in grado di svolgere molti dei compiti che normalmente richiedono l'intervento dell'Uomo.

Come tutto ebbe inizio

L'Intelligenza Artificiale (IA) (AI, acronimo di Artificial Intelligence in inglese) risale a metà del diciannovesimo secolo con le macchine intelligenti del secondo dopoguerra e la nascita dei primi calcolatori in grado di riprodurre parzialmente il ragionamento della mente umana. Questi furono i primi passi verso la creazione di computer sempre più potenti e nascita del concetto IA.

Dagli anni '40 agli anni '60 si svilupparono dunque le prime importanti basi teoriche su sistemi e macchine intelligenti. Prima della nascita del termine, già nel 1943, Walter Harry Pitts (un matematico) e Warren McCulloch (un neurofisiologo) entrambi statunitensi, scrissero un articolo intitolato "A Logical Calculus of Ideas Immanent in Nervous Activity" proponendo il primo modello matematico di una rete neurale.

L'articolo si concentra sull'applicazione del modello alla comprensione dell'attività neurale nel cervello e sulla possibile relazione tra l'attività neurale e la logica matematica. I due sostenevano che l'attività neurale può essere descritta utilizzando principi logici e che l'intelligenza umana può essere compresa in termini di elaborazione logica eseguita dai neuroni.

Questo articolo è considerato uno dei primi lavori significativi nel campo della neuroscienza computazionale influezando notevolmente lo sviluppo delle reti neurali artificiali negli anni successivi.

Uno dei momenti più significativi avvenne sette anni dopo questo articolo, quando il matematico inglese Alan Turing, considerato uno dei padri dell’informatica moderna, pubblicò nel lontano 1950 (già nel 1936 aveva posto le basi per i concetti di calcolabilità, computabilità e la macchina di Turing) sulla rivista Mind, l’articolo "Computing machinery and intelligence" divenuto noto come il "Test di Turing".

|

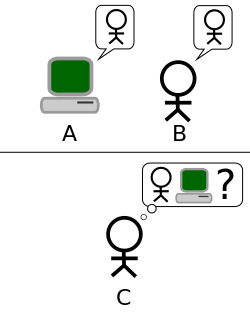

| Credit: it.wikipedia.org/wiki/Test_di_Turing |

Questo test fu concepito per valutare la capacità di una macchina di mostrare un comportamento intelligente indistinguibile da quello di un essere umano, gettando le basi per lo sviluppo dell'IA come campo di ricerca.

Il test di Turing mi fa venire in mente il test Voight-Kampf che si vede nel film "Blade Runner", usato dai poliziotti per capire se un sospettato è umano o un androide. Ancora oggi il Test di Turing viene utilizzato per distinguere un’intelligenza puramente umana da un’intelligenza artificiale.

Nell'articolo Turing prende spunto da un gioco, chiamato "gioco dell'imitazione", a tre partecipanti: un uomo A, una donna B, e una terza persona C. Quest'ultima è tenuta separata dagli altri due e tramite una serie di domande deve stabilire qual è l'uomo e quale la donna. Dal canto loro anche A e B hanno dei compiti: A deve ingannare C e portarlo a fare un'identificazione errata, mentre B deve aiutarlo. Affinché C non possa disporre di alcun indizio (come l'analisi della grafia o della voce), le risposte alle domande di C devono essere dattiloscritte o similarmente trasmesse.

Il test di Turing si basa sul presupposto che una macchina si sostituisca ad A. Se la percentuale di volte in cui C indovina chi sia l'uomo e chi la donna è simile prima e dopo la sostituzione di A con la macchina, allora la macchina stessa dovrebbe essere considerata intelligente, dal momento che - in questa situazione - sarebbe indistinguibile da un essere umano.

Fonte: https://it.wikipedia.org/wiki/Test_di_Turing

Grazie al lavoro di Turing presero vita diversi approcci nella comunità scientifica come la logica matematica e le reti neurali applicate dalla fine degli anni 2000 nell’ambito del Deep Learning (sottoinsieme del Machine Learning).

Nascita del termine "intelligenza artificiale"

Sempre negli anni '50, esattamente nel 1956, il termine "Intelligenza artificiale" come lo intentiamo oggi, fu coniato da John McCarthy, un informatico statunitense che vinse il Premio Turing nel '71, anche noto per aver realizzato il linguaggio di programmazione LISP (List Processor).

Lo stesso anno si tenne un convegno al Dartmouth College dove partecipò J. McCarthy insieme ad altri brillanti personaggi del campo della computazione per il sviluppo di sistemi intelligenti: Marvin Minsky, Claude Shannon (il “padre” della teoria dell’informazione e della teoria matematica della crittografia) e Nathaniel Rochester.

Su iniziativa di McCarthy, un team composto da dieci ricercatori aveva il compito di creare in solo due mesi una macchina con la capacità di simulare l'apprendimento e l'intelligenza umana.

Sempre nello stesso convegno, un'altra iniziativa fu quella proposta dai ricercatori Allen Newell e Herbert Simon i quali avevano già un programma chiamato Logic Theorist in grado di dimostrare vari teoremi di matematica.

Il programma per computer creato dai due ricercatori Newell e Simon con la partecipazione di J. C. Shaw progredì dando vita nel '57 ad un nuovo programma: il General Problem Solver (o G.P.S.), progettato per imitare le capacità di problem solving degli esseri umani; rappresentando uno dei primi programmi di IA.

Gli anni a seguire di questo memorabile convegno portarono a nuovi successi. Per mia comodità citerò in ordire crescente alcune importarti contributi in campo scientifico:

- 1950, Claude Elwood Shannon (ingegnere e matematico statunitense) mise insieme circuiti telefonici per costruire una macchina capace di apprendere. Un topo telecomandato noto come Theseus in grado di trovare la via d'uscita da un labirinto e di ricordarne il percorso.

Teseo dell'antica mitologia greca navigò nel labirinto del Minotauro e fuggì seguendo un filo (il filo d'Arianna) che aveva usato per segnare il suo percorso. Il Theseus di Shannon era capace di "ricordare".

- 1958, Frank Rosenblatt (psicologo) testa il primo dispositivo elettronico (una macchina di sei tonnellate) in grado di simulare a livello software e hardware il funzionamento dei neuroni prendendo spunto dalle teorie di Walter Harry Pitts e Warren McCulloch (1943). Il sistema prese il nome di Mark I Perceptron. Negli anni '60 fu il trampolino di lancio per le nuove innovazioni legate al machine learning (ML), un sottoinsieme dell’IA con regole statistiche che abilitano le macchine a migliorarsi tramite l’esperienza. Iniziò a prosperare a partire dagli anni '80.

- The Computer and the Brain: il matematico John von Neumann imita le funzioni neurali con l’uso di ripetitori telegrafici e valvole.

- 1959, Herbert Gelemter creò il Geometry Theorem Prover, un programma in grado di dimostrare teoremi di geometria complessi.

- Nasce Adaline e Madaline, la prima rete neurale applicata a un problema concreto: eliminare gli echi sulle linee telefoniche.

- 1963, James Slagle creò il programma Saint che aveva la capacità di risolvere problemi di calcolo integrale in forma chiusa.

- 1966, Joseph Weizenbaum crea il primo chatterbot chiamato Eliza, una parodia secondo Weizenbaum delle "domande di uno psicoterapeuta all'inizio di un intervento psichiatrico". Fu il primo tentativo di iterazione uomo-macchina.

- 1969, Il Carnegie institute of technology programma Dendral, l’algoritmo che costruisce la struttura di una molecola a partire dai dati dello spettrometro di massa.

- 1966/72, Viene progettato Shakey, il primo robot mobile "intelligente" su due ruote.

Gli eventi visti fino a questo momento hanno dato una piccola spinta al campo della ricerca degli anni settanta con differenti proposte di approccio all'IA, tra cui quella della IA simbolica basata sulla manipolazione di simboli e regole logiche, e l'IA connessionista sulla creazione di reti neurali artificiali (la SNARC fu considerata la prima macchina a rete neurale nel campo della IA creata nel 1950) utilizzate per compiti come il riconoscimento di pattern, l'apprendimento automatico e il controllo di robot.

L'inverno/i dell'intelligenza artificiale e la rinascita

Dopo anni di ricerca abbastanza fruttuosi qualcosa iniziò a non andare bene. Nonostante le promesse iniziali, molti dei progetti non raggiunsero i risultati sperati, manifestandosi delusione e scetticismo da parte della comunità scientifica e da chi la finanziava.

Inizia un periodo noto come "inverno dell'IA" (AI winter in inglese).

Molte aziende e istituzioni ridimensionarono o chiusero del tutto i loro progetti di ricerca durante questo periodo.

Le aspettative ottimistiche dell'epoca vennero presto smorzate a causa dalle capacità di calcolo dei Computer, rendendone difficile se non impossibile l'implementazione pratica di molti algoritmi e modelli di IA più complessi.

Ma non tutto è perduto. Anche in questi periodi apparentemente bui non mancarono importanti scoperte nel campo dell'apprendimento automatico e dell'elaborazione del linguaggio naturale.

Negli anni '60 e '70 l'attenzione fu rivolta allo sviluppo di sistemi esperti progettati per imitare le decisioni prese da specialisti umani in campi specifici.

Si tratta di programmi intelligenti che utilizzano regole e logica per risolvere problemi complessi, fornendo consulenza o prendendo decisioni in base alle informazioni fornite loro. Un sistema esperto è composto da tre componenti principali: base di conoscenza, motore di inferenza e un'interfaccia utente.

Esempi di sistema esperto degni di nota sono: DENDRAL, sviluppato negli anni '60 presso l'Università di Stanford per l'analisi spettroscopica dei composti chimici organici e MYCIN, anche lui sviluppato all'Università di Stanford negli anni '70 per la diagnosi e il trattamento delle infezioni batteriche del sangue.

È anche di questo decennio ('78) il programma R1 (chiamato interamente XCON) scritto in OPS5 da John P. McDermott al Carnegie Mellon University.

XCON è stato utilizzato per la prima volta nel 1980 consentendo alla Digital Equipment Corporation un risparmio di circa 40 milioni di dollari l’anno, avviando l'IA nel campo industriale.

Nel frattempo nascono anche la programmazione logica e la fuzzy logic, due nuovi paradigma dell’IA.

Sempre nell'80 apparvero i sistemi esperti di seconda generazione introducendo questa volta il modello probabilistico e non il deterministico.

Grazie a questi piccoli passi avanti si tornò pian piano ad investire nella ricerca realizzando di lì a poco anche programmi in grado di giocare a scacchi come fanno i giocatori umani.

Non si dovrà aspettare tanto prima che accada. Un primo esempio di macchina per giocare a scacchi contro il Computer fu ideata nell'85 da uno studente laureato alla Carnegie Mellon University. Il suo nome era Feng-hsiung Hsu. La chiamò ChipTest.

La prima versione era capace di ricercare circa 50.000 mosse al secondo. Con la nuova versione dell'87 che prese il nome di ChipTest-M arrivò alle 500.000 mosse al secondo.

Murray Campbell (un suo compagno di classe) si unì a lui nel '89. Entrambi furono assunti per lavorare presso l'IBM Research.

ChipTest fu il predecessore di Deep Thought, quest'ultimo portò più avanti allo sviluppo del famoso supercomputer Deep Blue.

Dopo l'inverno/i dell'IA

|

| Fonte: James the photographer - https://www.flickr.com/photos/22453761@N00/592436598/ |

La ripresa più significativa si ebbe negli anni 90' con la fine degli inverni dell'IA .

Si dovrà aspettare il ventunesimo secolo per i forti investimenti e maggiore interesse, quando l'apprendimento automatico è applicato con successo a molti problemi nel mondo accademico e industriale grazie a nuovi metodi, a nuovi e potenti hardware per computer e alla raccolta di immensi set di dati.

Uno degli eventi più celebre dell'epoca fu la partita di scacchi uomo-macchina tra il campione mondiale Garri Kimovič Kasparov ed il supercomputer progettato da IBM, l'IBM Deep Blue.

Il team completo di sviluppo di Deep Blue era composto da: Jerry Brody, Murray Campbell, Feng-hsiung Hsu (il progetto originale del gioco degli scacchi contro il computer si chiamava come detto prima ChipTest, progettato nell'85 proprio da Hsu), A. Joseph Hoane Jr. Joel Benjamin e Chung-Jen Tan.

|

| Garri Kimovič Kasparov vs Deep Blue - (Feng-hsiung Hsu) |

La prima partita delle sei fu disputata a Philadelphia il 10 Febbraio del '96, vinta da Kasparov. L'anno successivo (New York, dal 3 Maggio all'11 Maggio '97) grazie ad un aggiornamento (poteva calcolare fino a 200 milioni di mosse al secondo), Deep Blue ha la meglio sul campione in carica in sole 19 mosse. Il risultato finale di questo torneo fu due vittorie per IBM, una per il campione e tre pareggi.

Questo strepitoso successo diede il via allo sviluppo di software scacchistico (anche di altri giochi, come ad esempio il Go) in grado di superare le capacità umane, sconfiggendo i migliori campioni.

Non solo supercomputer come Deep Blue. Negli anni 90' sono stati compiuti notevoli progressi anche nella robotica. Un esempio è ASIMO (acronimo per Advanced Step in Innovative MObility) sviluppato da Honda nel 2000. Era l'umanoide più recente di una serie di robot iniziata nell'86. Poteva camminare, correre, salire e scendere le scale, raccogliere oggetti e interagire con le persone. Un altro esempio di robot dell'epoca è il cane robotico Sony AIBO (1999) dotato di capacità di riconoscimento vocale e interazione con l'ambiente circostante.

AI debole (weak AI) e AI forte (strong AI)

Sarebbe utile per testare ipotesi sulle menti, ma in realtà non sarebbero menti

(John Searle)

Per andare avanti nella storia dobbiamo tornare indietro.

Nel 1980, John Searle (un filosofo statunitense) pubblicò Minds, Brains and Programs per dimostrare in modo conclusivo che è impossibile che i computer (ora o in futuro) possano letteralmente pensare, introducendo il dibattito intorno al tema dell'IA debole/forte in qualche misura discusso ancora oggi.

Per sostenere questa ipotesi, mise in atto un esperimento mentale chiamato "Stanza Cinese" che sfidava anche il test di Turing.

Immagina un madrelingua inglese che non conosce il cinese chiuso in una stanza piena di scatole di simboli cinesi (un database) insieme a un libro di istruzioni per manipolare i simboli (il programma). Immagina che le persone fuori dalla stanza inviino altri simboli cinesi che, sconosciuti alla persona nella stanza, sono domande in cinese (l'input). E immagina che seguendo le istruzioni del programma l'uomo nella stanza sia in grado di distribuire simboli cinesi che sono risposte corrette alle domande (l'output). Il programma consente alla persona nella stanza di superare il test di Turing per capire il cinese ma non capisce una parola di cinese.

Searle continua dicendo: "Il punto della discussione è questo: se l'uomo nella stanza non capisce il cinese sulla base dell'implementazione del programma appropriato per comprendere il cinese, allora nemmeno nessun altro computer digitale lo fa solo su quella base perché nessun computer, in quanto computer, ha tutto ciò che l'uomo non ha.

Fonte: https://plato.stanford.edu/entries/chinese-room/

Il dibattito nato al tempo della Stanza Cinese di John Searle tra questi tipi di sistemi è stato un tema centrale nella ricerca e nello sviluppo. La prima, ha fatto enormi progressi e viene utilizzata in larga scala, la seconda è tutt'oggi un obiettivo ambizioso che richiede ulteriori avanzamenti nel campo tecnologico e scientifico.

Tuttavia, grazie ai film di fantascienza su Intelligenza Artificiale possiamo vivere anche se per poco un futuro forse non lontano. Film come Metropolis, 2001 Odissea nello spazio, Terminator, L'uomo bicentenario, Ex Machina, Interstellar, sono tutti un esempio tangibile.

Questo ipotetico futuro sarà l'era delle macchine con Superintelligenza Artificiale (Artificial Super Intelligence - ASI) che va oltre l'IA forte, in grado teoricamente di sostituire l'Uomo in qualsiasi attività, dimostrando consapevolezza di sé.

Avverrà fra qualche decennio o fra 100 anni? Per il momento solleva importanti considerazioni etiche, scientifiche e di sicurezza che devono essere affrontate man mano che l'IA continua a progredire.

Differenza AI debole - AI forte

A questo punto ti starai chiedendo qual è la differenza fra IA debole e la forte. Giusto?

Bene. Il termine "intelligenza artificiale debole" (o IA ristretta) si riferisce ai sistemi che possono agire su diversi tipi di funzioni complesse umane, senza una comprensione generale o una vera e propria coscienza.

Possono farlo grazie ad algoritmi e modelli di Machine Learning, ma non sono veramente intelligenti come gli esseri umani perché non capaci di pensare in maniera autonoma.

Esempi di questo tipo sono gli assistenti virtuali come Siri e Alexa.

Parlando invece di "intelligenza artificiale forte" si descrivere una sorta di intelligenza superiore che avrebbe raggiunto o addirittura superato le capacità cognitive umane.

L'IA di oggi e del futuro

Dall'articolo A Logical Calculus of Ideas Immanent in Nervous Activity (scritto nel '43 da Walter Harry Pitts e Warren McCulloch) ad oggi ne abbiamo fatta di strada.

Negli ultimi 20 anni, la tecnologia ha trasformato velocemente molti aspetti della vita moderna, nel lavoro e nella comunicazione.

Con l'Internet ad alta velocità, i dispositivi mobili, i siti web, la nascita dei social media e le piattaforme di condivisione, possiamo in qualsiasi momento informarci, comunicare e condividere con chiunque in tutto il mondo.

Grazie ai progressi nelle tecniche di machine learning e deep learning abbiamo oggi applicazioni per il riconoscimento vocale, la traduzione automatica, il riconoscimento facciale e delle immagini, l'analisi dei dati e molte altre App che mirano al miglioramento della nostra quotidianità, come nel campo della salute e nel settore industriale.

Anche l'elaborazione del linguaggio naturale (NLP) negli ultimi anni ha compiuto passi da gigante, consentendo alle macchine di comprendere e rispondere al linguaggio umano con più precisione. ChatGPT e Writesonic sono sicuramente le più famose per il momento.

Insomma, siamo già strapieni di IA: dalle organizzazioni Big Tech come Google, Microsoft e Amazon al settore sanitario, finanziario e dei trasporti come ad esempio le auto senza conducente.

A questo punto c'è da chiedersi se tutto questo può in qualche modo nuocere all'Uomo. Dobbiamo preoccuparci dello sviluppo dell'intelligenza artificiale?

Per molti questo repentino cambiamento è un bene e sarà ancor meglio in futuro, per altri forse non lo è e non lo sarà mai.

Pensa a come sarebbe l'alternativa. Se tu e il grande pubblico non vi informate e non vi impegnate, allora lasciamo che siano pochi imprenditori e ingegneri a decidere come questa tecnologia trasformerà il nostro mondo.

Questo è lo status quo. Questo piccolo numero di persone in alcune aziende tecnologiche che lavorano direttamente sull'IA capisce quanto sta diventando straordinariamente potente questa tecnologia. Se il resto della società non si impegna, allora sarà questa piccola élite a decidere come questa tecnologia cambierà le nostre vite.

Come sarà il nostro futuro?

Forse non c'è ne rendiamo conto, viviamo già immersi nel futuro. Anche se i cambiamenti più profondi devono arrivare, questa tecnologia sempre più avanzata e autonoma giocherà un ruolo importante nella società.

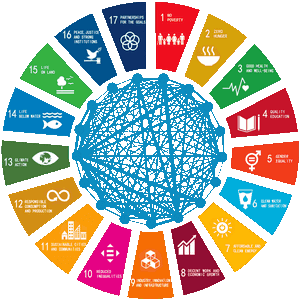

L'AI4SDGs Think Tank ha aggiornato recentemente la lista di progetti e proposte basati sull’IA (436) suddivise in 17 categorie sottoscritta nel 2015 da oltre 190 paesi ONU. L'obiettivo è promuovere l'uso positivo dell'IA per lo sviluppo sostenibile delle Nazioni Unite entro il 2030. Se hai qualche minuto dacci un'occhiata.

In passato, come detto nel corso di questo articolo, i ricercatori che lavoravano allo sviluppo della tecnologia IA erano pochi rispetto ad oggi così come i finanziamenti. Negli ultimi anni le cose sono cambiate velocemente e le risorse disponibili sono notevolmente aumentate. Dovremmo aspettarci che il campo di ricerca continui ad avanzare sempre più rapidamente grazie a nuovi studenti e ricercatori con nuove idee come l'apprendimento per rinforzo, il calcolo quantistico e il calcolo neuromorfico. Anche l'IA stessa contribuisce al suo sviluppo tramite la Neural architecture search (NAS).

Fonte: Breve storia dell’Intelligenza Artificiale di Valerio Rosso

The brief history of artificial intelligence: The world has changed fast – what might be next?

Intelligenza artificiale: come funziona e quali usi trova nella vita quotidiana di Luigi Marino

https://forward.recentiprogressi.it/wp-content/uploads/2018/03/FWD08.pdf

https://cloud.google.com/learn/what-is-artificial-intelligence?hl=it

Nessun commento:

Posta un commento